Статья обновлена 07.11.2023

Что такое парсинг? Парсинг — это автоматический сбор и систематизация сведений из интернета. Что такое парсер, как парсить и что это значит, виды парсеров — всё это разберем в статье. Также рассмотрим тонкости применения инструмента в программировании, маркетинге и многое другое.

В переводе с английского языка «parsing», или спарсить, — это провести грамматический разбор слова или текста. Первоначальное значение пришло из латыни: парсинг в переводе означает «часть речи» — «pars orationis».

При парсинге строка или текст разбиваются на компоненты. Затем полученные данные преобразуются в формат, подходящий для обработки и использования. По сути, один формат данных превращается в другой, более читаемый. Допустим, вы получаете информацию в необработанном коде HTML, а парсер принимает его и преобразует в формат, который вам будет легко проанализировать и понять.

Парсинг предлагает инструменты, которые помогают извлекать нужные вам значения из любых форматов данных. Извлеченные сведения сохраняются в отдельном файле — либо на локальном компьютере, либо в облаке или на хостинге, либо напрямую в базе данных. Это происходит автоматически.

Этот термин встречается не только в SEO. Что значит парсить в программировании? Это выглядит так:

1) работающий парсер посылает запрос типа GET на сайт-«донор», который должен в ответ направить данные;

2) в результате этого запроса создается HTML-документ, который будет проанализирован программой;

3) парсер ищет в нем необходимые пользователю данные и преобразует их в нужный формат.

Есть 2 варианта выполнения веб-парсинга:

- доступ к сайту www через протоколы HTTP, HTTPS или веб-браузер;

- доступ с использованием бота.

Парсинг — не запрещенный метод сбора и обработки информации. Часто даже сайты госслужб предоставляют данные для публичного использования. Поскольку сбор такой информации — это обработка огромных массивов данных, на помощь приходят парсеры.

Что такое программа парсер и как она работает

Некоторые не понимают разницы: парсер или парсинг? Первое — это программное обеспечение, а второе — процесс.

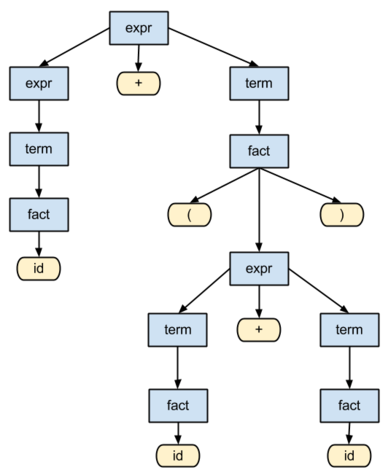

Программа для парсинга предназначена для автоматической обработки и извлечения данных. Для обработки заданного текста такое ПО обычно применяет отдельный лексический анализатор. Его называют токенайзером или лексером. Токенайзер разбивает все входные данные на токены — отдельные символы, слова. Полученные таким образом токены служат входными символами для парсера.

Затем программа обрабатывает грамматику входных данных, анализирует их и создает синтаксическое древо. На этой основе идет дальнейшая работа парсера с информацией — генерация кода или выборка по определенным критериям.

Парсинг данных: методы

Есть два основных метода парсинга: нисходящий и восходящий. Обычно они различаются последовательностью, в которой создаются узлы синтаксического древа.

- «Сверху вниз»: при нисходящем методе парсер выполняет поиск сверху, с начального символа в коде, и ищет подходящие ему синтаксические связи. Таким образом, древо синтаксического анализа разрастается сверху вниз — в направлении более детальной разбивки.

- «Снизу вверх»: восходящий парсер начинает снизу, с самого нижнего символа строки, а затем устанавливает всё более крупные синтаксические связи. Это делается, пока не будет достигнут начальный символ кода.

Но метод работы — не самое важное. Хорошо сделанный парсер будет сам «видеть», какая информация необходима пользователю. Он выберет нужные данные в соответствии с заранее написанным кодом и правилами синтаксического анализа и преобразует их в формат JSON, CSV или в таблицу Excel.

Важно отметить, что сам парсер информации не привязан к определенному формату данных. Это просто инструмент, который после сбора и анализа преобразует один формат в другой. Как именно он преобразует его и во что, зависит от текущих задач.

Для чего применяется парсинг

Парсинг используется для преобразования текста в новую структуру в следующих случаях.

- Чтение программного кода — Java, SQL и других языков программирования. Этим занимаются парсеры баз данных. Как это работает? Парсер предоставляет программе структуру данных, с помощью которой можно сгенерировать машинный код.

- Чтение HTML-кода с помощью парсера исходного кода страницы. Для компьютера HTML-код — это просто строки символов, которые должны быть проанализированы в браузере. Парсер предоставляет описание веб-страницы как структуры данных, которые затем компонуются в нужном порядке и выводятся в файл.

- Анализ XML-разметки. Специальные парсеры XML отвечают за обработку этого типа документов и готовят содержащуюся в них информацию для дальнейшего использования.

- Чтение URL-адресов и интернет-протоколов HTTP и HTTPS. Парсеры разбивают сложные схемы URL-адресов и протоколов на иерархическую структуру.

- Поисковые системы. С помощью парсеров поисковой системы боты выбирают релевантный для них текст из контента сайта. После первичной выборки данные обрабатываются, а результаты такого SEO-парсинга становятся доступны для просмотра.

В цифровом маркетинге парсинг применяют, чтобы получить и проанализировать определенную информацию из контента нужных веб-ресурсов.

Парсинг страницы: сферы применения

Парсинг страниц, ведущий сбор информации из веб-контента сайтов, используется в различных сферах — для продаж, маркетинга, финансов, электронной коммерции, сбора сведений о конкурентах и так далее. Парсинг данных с сайта активно применяют в следующих областях.

Розничный маркетинг

В розничной торговле есть много возможностей использования парсинга. Например, мониторинг цен конкурентов или аналитика рынка, где метод применяют для обработки данных и извлечения из них ценной для маркетологов информации.

Пример

Для электронной коммерции может потребоваться огромное количество изображений и описаний товаров. Их нельзя просто создать за пару-тройку дней, так как даже просто скопировать и вставить каждый займет определенное время. Гораздо проще и быстрее создать парсинг и быстро «выцепить» всё нужное. Или взять аналитику рыночных цен — регулярный парсинг веб-страниц конкурентов поможет своевременно замечать и учитывать все изменения на рынке.

Анализ рынка акций

Раньше анализ фондового рынка ограничивался изучением финансовой отчетности компаний и, соответственно, инвестированием в наиболее подходящие ценные бумаги. Сегодня каждая новость или изменения настроений в обществе или геополитике важны для определения текущих трендов. Как получать такие данные? Здесь помогает парсинг. Он позволяет получить всю информацию о настроениях фондового рынка и увидеть общую картину. К тому же проще и быстрее извлекать годовые отчеты и все стандартные финансовые данные с любого сайта с помощью парсинга, а не вручную.

Машинное обучение

По сути каждый парсер проходит обучение. Это позволяет ему обнаруживать закономерности. Однако чтобы установить нужные связи, необходимо передать в «компьютерный разум» много данных и помочь связать одно с другим. Часто парсеры применяются в технологиях AI, чтобы обеспечить регулярный поток обучающей информации.

Парсер почты

Что это такое? Парсинг электронной почты позволяет анализировать входящие и исходящие сообщения. Затем их содержимое можно обработать и интегрировать в различные приложения c помощью программного интерфейса API.

Электронная почта — одна из наиболее загруженных данными форм современного общения. Обычная отправка одного электронного письма собирает, передает и интерпретирует около 100 Кб данных. Если умножить на миллиарды писем, можно понять, почему компаниям сложно управлять такими объемами информации, обрабатывать ее и искать нужные им сведения. Решение проблемы сегодня берут на себя специальные парсеры.

Большинство компаний применяет решения на основе API для 3 основных видов приложений.

- Поддержка клиентов. Парсинг обеспечивает фиксацию взаимодействий с клиентами по электронной почте, доставку нужных сообщений пользователям, сбор и анализ входящих сообщений для хранения и отображения в приложениях поддержки.

- Приложения для управления взаимоотношениями с клиентами, CRM. Приложения CRM часто записывают всю переписку с клиентом, чтобы сохранились ценные данные из истории взаимоотношений. А направляя ответы клиентов через систему парсинга, приложения CRM могут получать предварительно проанализированные данные.

- Социальные приложения. Приложения для соцсетей часто позволяют общаться по электронной почте, чтобы облегчить пользователям отслеживание беседы. Парсинг входящей почты — простой и быстрый способ настроить почтовые приложения так, чтобы они росли по мере масштабирования переписки в соцсетях.

Парсинг и краулинг: отличия

Парсинг иногда путают с краулингом, потому что эти процессы схожи. Оба имеют идентичные варианты использования. Разница — в целях.

Обе операции «заточены» на обработку данных с сайтов. Процессы автоматизированы, поскольку задействуют роботов-парсеров. Что это такое? Боты для обработки контента.

И парсинг, и краулинг анализируют веб-страницы и ищут данные с помощью программных средств. Они никак не изменяют информацию, представленную там, и работают с ней напрямую.

Парсинг собирает сведения и сортирует их для выдачи по заданным критериям. Это необязательно происходит в интернете, где делают парсинг веб-страниц. Речь идет о данных, а не о том, где они хранятся.

Пример

Вы хотите поработать над ценовой аналитикой. Для этого вы запускаете созданные парсеры товаров и цен на них, чтобы собрать информацию с Avito или из любого интернет-магазина. Таким же образом можно анализировать данные фондового рынка, объявления по недвижимости и так далее.

Краулинг, или веб-сканирование, — прерогатива поисковых ботов, или веб-пауков. Краулинг включает в себя просмотр страницы целиком в поисках информации и ее индексацию, включая последнюю букву и точку. Но никакие данные при этом не извлекаются.

Интернет-бот, или парсер поисковой системы, — тоже систематически просматривает всемирную паутину, чтобы найти сайты и описать их содержимое. Самое важное отличие от краулера — он собирает данные и систематизирует их.

То, что делают Google или Яндекс — простой пример веб-сканирования. Это тоже своего рода парсинг. Что это такое простыми словами? Когда поисковые машины сканируют сайты и используют полученную информацию для индексации

Как проходит веб-парсинг

Принцип работы парсеров для веб-страниц одинаков, обычно он состоит из 3 этапов.

1. Запрос-ответ

Первый шаг — запросить у целевого сайта содержимое определенного URL-адреса. Взамен парсер получает запрошенные сведения в формате HTML.

2. Разбор и извлечение

Синтаксический анализ обычно применяется к любому компьютерному языку. Это распознавание кода в виде текста и создание структуры в памяти, которую компьютер может понять и с которой будет работать.

Парсер берет HTML-код и извлекает оттуда нужную информацию — заголовок страницы, абзацы, подзаголовки, ссылки, выделения жирным, нужные темы и так далее, проводя парсинг текста.

3. Загрузка данных

Полученные данные загружаются и сохраняются. Формат файла задается так, чтобы его можно было открыть в другой нужной программе. Для Google Таблиц это, например, CSV, для парсинга базы данных — JSON.

Готовое решение или собственный парсер

Предположим, вам нужно проводить регулярный мониторинг, чтобы отслеживать цены других поставщиков. И каждый раз, когда ваш конкурент снижает цены, должно приходить соответствующее уведомление.

Чтобы решить эту задачу, возможны два варианта — создать собственный парсер или заказать готовый на аутсорсе. Что выбрать? При принятии решения стоит учитывать различные факторы. Давайте рассмотрим возможности и результаты для обоих вариантов.

Создание собственного парсера данных

Допустим, вы решили создать собственный парсер и знаете, как написать код. Самостоятельно парсить — что это даст и нужно ли вам это? Такое решение предоставляет несколько преимуществ.

- Парсер можно настроить и адаптировать для различных задач.

- Собственный парсер дешевле. Как показывает практика, обычно создать собственный инструмент даже с использованием специальных сервисов обойдется дешевле, чем покупать готовый.

- Вы контролируете параметры, которые необходимо выбирать при обновлении и обслуживании парсера.

Недостатки:

- придется нанять и обучить сотрудников;

- нужно купить или арендовать быстрый сервер, чтобы анализировать данные с нужной скоростью;

- понадобится время, чтобы сработаться с технической командой, всё спланировать и протестировать.

Если вам нужно обработать большой объем информации, то понятно, для чего вам нужен парсер с широкими возможностями. Например, важно контролировать не одного, а несколько десятков крупных конкурентов. Если подобных масштабных задач нет, то собственный сложный парсер не нужен.

Парсеры данных на аутсорсе

В чем преимущества готового инструмента, который проанализирует нужные данные по конкурентам за вас?

- Не нужно тратить деньги на человеческие ресурсы, что значит: всё будет сделано командой разработчика, включая обслуживание парсера и сервера.

- Любые возникающие проблемы будут решены намного быстрее. Компании, которые продают готовое решение, обладают обширным опытом и хорошо знакомы со своими технологиями.

- Вряд ли парсер выйдет из строя, поскольку он будет протестирован и усовершенствован в соответствии с требованиями рынка.

У готового решения есть и недостатки:

- будет стоить дороже;

- вы не сможете контролировать все параметры и быстро вносить изменения.

У обоих вариантов есть свои плюсы и минусы, и трудно сказать, как сделать лучше и как правильно парсить. На самом деле это — вопрос объема данных. Опытный разработчик, который разбирается, что значит в программировании парсинг, может сделать для вас простой парсер сайтов за неделю. Вы также можете создать его сами, используя онлайн-сервисы. Но если перед вами стоит сложная задача, на это могут уйти месяцы.

Таким образом, если вы — крупная компания и анализируете большие массивы информации, вам придется привлекать сторонние компании для разработки парсера данных и его сопровождения. Если же вы — представитель малого бизнеса и вам нужен простой парсер, то лучше создать свой собственный, например, с помощью специальных программ.

Программа для парсинга сайтов: лучшие сервисы

Какой выбрать парсер? Для сбора информации важно не просто подобрать программное решение, но и предотвратить блокировку вашего IP-адреса в процессе. А также обеспечить обход капчи, построение синтаксического древа на основе заданных значений, удаление заголовков, выборку данных, представленных в нужном формате. Всё это требует усилий.

Чтобы вы могли быстро выбрать инструмент для решения таких задач, мы подготовили описания и списки преимуществ популярных решений для парсинга. В подборке вы увидите и простые онлайн-сервисы, и браузерные плагины.

При выборе парсера следует учитывать форматы вывода, поддерживаемые сервисом, его способность работать с современными сайтами — например, поддержку элементов управления Ajax, а также формы отчетности и возможности автоматизации.

ScrapingBee Parser

Программа представляет API-интерфейс для парсинга через браузер или через защищенный прокси-сервер. Она может запускать JavaScript на сайтах и изменять прокси для каждого запроса, чтобы получать HTML-коды без блокировки. У ScrapingBee Parser также есть специальный API для связки с поиском Google.

- Корректно обрабатывает сайты, использующие JavaScript.

- Для обхода блокировок меняет прокси-сервера при запросах.

- Импортирует собранные данные в любые форматы, включая Google Таблицы или результаты парсинга в виде полей.

- Имеет собственный плагин для браузера Chrome.

- Способен справиться с крупными сайтами типа Amazon.

- Поддерживает парсинг запросов поиска Google.

Xtract.Io

Масштабируемая платформа для извлечения данных, которую можно настроить для парсинга файлов и структурирования различной информации с сайтов, а также документов в виде PDF и текста, исторических данных, электронной почты. Сервис даже способен работать как парсер сообщений в социальных сетях. Преобразовывает все данные в готовый для просмотра формат.

- Обработка разных типов данных по шаблонам — парсинг товаров и информация о каталоге, финансах; сведения об аренде и местоположении, список компаний и их контакты, объявления о вакансиях, отзывы и рейтинги и так далее.

- Легкая интеграция полученных данных в бизнес-приложения с помощью API-интерфейсов.

- Автоматизация процесса извлечения данных — не нужно задумываться, как настроить парсер, так как есть рабочие шаблоны, которые можно модифицировать под свои потребности.

- Экспорт данных в желаемом формате: JSON, текстовый файл TXT, код HTML, таблицы CSV, TSV и так далее.

- Реализован обход капчи с помощью ротации прокси-серверов во время запросов.

Scraper API Parser

Сервис дает обширные возможности обработки HTML-кода и работает как парсер по ключам. Он позволяет собирать данные через API и браузер, обходить блокировки и капчи. Результаты легко интегрировать в собственный проект, если настроить отправку запроса GET в конечную точку Сети с ключом API и URL-адресом. Эта функция дает возможность использовать ScraperAPI как граббер сайтов.

- Помогает отображать JavaScript на анализируемых страницах.

- Имеет дифференциацию типов запросов и возможность настраивать заголовки.

- Позволяет работать с большими массивами данных с высокой скоростью.

- Создает масштабируемые проекты.

- Предоставляет управление прокси в различных локациях.

Import.Io

Сервис работает как парсер веб-ресурсов: помогает сформировать массив данных путем их импорта из любых страниц сайта. Парсить файл можно с последующим экспортом данных в формат CSV. Полученную информацию через API и веб-перехватчики можно размещать сразу в базу данных собственного проекта и в различные приложения. Сервис работает и как граббер контента.

- Легкая обработка заполняемых форм и процессов регистрации пользователей с логином на сайтах, с которых нужно получить данные.

- Настройка обработки данных через планировщик событий, автоматизация запуска и нужных действий.

- Хранение собранных сведений в облачном сервисе Import.Io.

- Получение аналитических данных, причем не только в обычном формате, как делает текстовый парсер, но и с элементами визуализации, инфографики.

Dexi Intelligent Parser

Сервис позиционирует себя как платформу для скоростного парсинга запросов больших объемов данных с немедленной выдачей результатов. Прост в настройке, позволяет одновременно вести несколько широкомасштабных парсеров проектов.

- Быстрая и точная обработка данных с различных платформ.

- Скоростная работа с большим объемом данных.

- Полученные сведения доступны для немедленного анализа и выгрузки в удобных форматах.

ParseHub

Удобный парсер сайтов онлайн. Усовершенствованный алгоритм позволяет парсить нужные данные, просто кликая по кнопкам. Затем полученную информацию можно загружать в удобном виде для дальнейшей обработки.

- Настройка тонкой фильтрации собираемых данных уже после выдачи результатов парсинга.

- Интуитивно понятный интерфейс.

- Возможность планировать все операции парсера — результаты при этом собираются на выделенных серверах.

Есть также десктопная программа ParseHub, которая позволяет спарсить даже сложные и динамические сайты с разветвленными сценариями. Несмотря на широкий функционал, ParseHub отличается простотой настроек и понятным интерфейсом. Он может выполнять парсинг с нескольких страниц одновременно, взаимодействовать с Ajax, формами, раскрывающимися списками и так далее. Сама обработка информации происходит на серверах Parsehub, нужно только создать парсеру инструкцию в приложении.

- Данные могут быть извлечены с любого сайта в интернете.

- Использует шаблоны и наборы данных, чтобы получать сведения о товарах, их ценах, изображениях и тематических обзорах.

- Ведет агрегацию данных с нескольких сайтов.

- Предлагает веб-парсинг для анализа отрасли, маркетинга и конкурентов.

- Применяет REST API для создания мобильных и онлайн-приложений.

- Интегрированный планировщик позволяет задать выполнение парсинга ежечасно, ежедневно или еженедельно.

- Обеспечивает доступ к API, экспорт данных парсинга в файл JSON или CSV.

DataStreamer

Сервис располагает средствами расширенного лингвистического анализа. Это дает ему возможность работать не только с контентом сайтов, но и с социальными сетями. Для полноценного парсинга достаточно задать набор метаданных, в том числе тегов, по которым будет проводиться поиск.

- Встроенные средства лингвистического анализа и полнотекстового поиска на базе проверенных алгоритмов.

- Обработка данных по шаблонам, экспорт содержимого по тому же принципу, по которому работает парсинг поисковой выдачи.

- Работает на собственных надежных серверах.

- Простые администрирование и настройка.

Apify SDK

Библиотека для JavaScript, поддерживающая широкие возможности парсинга и краулинга. Помогает вести разработку и парсинг с помощью так называемых безголовых браузеров — ПО, которое работает с URL-адресами напрямую, без отрисовки содержимого на экране.

- Легко создать практически любой парсер под конкретную задачу.

- Дает возможность собирать нужные данные по всей Сети, действуя как поисковый бот.

- Есть облачные решения и возможность работать на локальном компьютере.

- Потребляет меньше ресурсов, так как использует JS.

Sequentum Parser

Визуально простое решение для работы с многопоточными массивами информации. Парсинг осуществляется через понятный графический интерфейс, что помогает быстро настроить работу и получать нужные данные.

- Быстрый парсинг по сравнению с другими решениями.

- Использует API, что позволяет делать запросы напрямую и передавать результаты прямо в базу данных.

- Настройка различных потоков обработки данных дает возможность одновременно контролировать разные проекты.

Scrapingdog

Высокопроизводительный сервис парсинга, предоставляющий миллионы прокси. С его помощью можно спарсить базу данных с такими возможностями, как рендеринг JavaScript и обход капчи.

Scrapingdog предлагает следующие виды парсеров.

- Программное обеспечение для пользователей с неглубокими техническими знаниями. Можно вручную настроить практически всё — от рендеринга JavaScript до обработки прокси-серверами премиум-класса. Также предоставляет экспорт в формат JSON, если указать теги и атрибуты для сбора нужной информации.

- API-интерфейс для разработчиков. Позволяет парсить сайты, просто создавая запросы по URL внутри API. Полная инструкция в документации.

Mozenda

Коммерческое программное обеспечение для парсинга, разработанное для всех видов задач по извлечению данных. Возможности Mozenda по парсингу данных доступны как на локальном ПК, так и в облаке. ПО поможет подготовить сведения для анализа стратегии, финансов, маркетинговых исследований, торговых операций и продаж. Подходит для больших корпораций с крупными проектами. Mozenda также может создать индивидуальный парсер по запросам заказчика.

- Одновременная обработка больших массивов данных.

- Парсинг данных с сайтов из разных геолокаций.

- Сбор данных и их обработку можно контролировать через API.

- Настройка уведомлений по электронной почте.

- Шаблоны для построения парсера.

- Интегрируется в любую систему.

- Работает с парсингом файлов в формате PDF.

Webharvy

ПО для простого парсинга. Десктопная версия загружается на локальный компьютер и не использует облачные ресурсы. Если вы работаете над небольшими проектами и ищете ответ на вопрос, как пользоваться парсером без лишних усилий, установите Webhatvy. С его помощью можно обрабатывать данные по входу в систему, регистрации пользователей и даже отправке форм. Позволяет распарсить несколько страниц за считанные минуты. Однако есть ограничения. Если нужно выполнить крупномасштабный парсинг, это может занять много времени, так как возможности зависят от технических характеристик локального компьютера. Также ПО не поддерживает обход капчи при сборе данных парсером.

- Функция визуального сканирования позволяет определять правила парсинга.

- Оплата за программное обеспечение проводится только один раз.

- Отлично подходит для простых задач по парсингу.

80legs

Ресурс предлагает возможности быстрого парсера ссылок. Что это такое и для чего нужен этот функционал? Проще говоря — вам необходимо обработать много простых запросов, переходя по многочисленным линкам с веб-страниц. Однако в прошлом сервис использовали для DDOS-атак, поэтому при повышенной частоте парсинга он может блокироваться. Работать с ним просто — достаточно ввести один или несколько URL-адресов, с которых нужно получить данные. Поддерживает обработку до нескольких тысяч веб-страниц.

- Стабильная платформа и быстрый парсер.

- Можно включить в парсинг результаты поисковой выдачи и использовать возможности поисковых ботов.

- Гибкая настройка всех параметров — какие данные будут обрабатываться и по каким ссылкам переходить с каждого указанного URL.

- Работает как автоматический парсер. Что это значит? Переход по любым встреченным ссылкам происходит автоматически в соответствии с изначально заданными настройками.

- Публикация результатов по мере прогресса парсинга.

- После завершения парсинга полученные результаты можно загрузить на свой компьютер или в любой облачный сервис.

Grepsr

Крупная платформа для парсинга веб-страниц. Поможет собрать нужные данные, отсортировать их и интегрировать в нужную систему аналитики. Позиционируется как сервис для всех — от маркетологов до инвесторов. Позволяет выполнить парсинг новостей с других сайтов, сбор финансовых данных или сведений о конкурентах, обработку информации для программ генерации лидов и так далее.

- Может использоваться для небольших проектов — например, для создания парсера адресов в файле или обработки данных конкурентов.

- Позволяет спарсить цены, товарные категории, каталоги продуктов и другие важные сведения.

- Дает возможность сбора финансовых и рыночных данных, дистрибьюторских цепочек, новостей и другого тематического контента.

- Можно задать вопрос на отдельном коммуникационном портале ресурса по любому из проектов. Это техническая поддержка, обсуждение требований и отслеживания статуса проекта — всё в одном.

- Поддерживает несколько форматов вывода.

- Может рассылать результаты по электронной почте.

- Неограниченная пропускная способность.

ScrapeBox

Программное обеспечение для настольных ПК, позволяющее выполнять многие задачи парсера. Программа вышла в 2009 году и продолжает развиваться до сих пор — регулярно выпускаются обновления. Помогает парсить практически любой тип данных — от электронной почты до ключевых слов.

- Установка парсера возможна на локальном компьютере и не зависит от подключения к интернету.

- Обеспечивает быструю многопоточную работу с несколькими одновременными подключениями.

- Позволяет ввести любые настройки в соответствии с задачами бизнеса. Полностью настраиваемый парсинг благодаря большому количеству встроенных сервисов.

- Более 30 бесплатных дополнений для расширения программы дополнительными функциями.

Scrapy

Фреймворк для парсинга и веб-сканирования с открытым исходным кодом, написанный на Python. Первоначально разработанный для парсинга, он также может использоваться для извлечения данных с помощью API или даже в качестве универсального поискового робота. Отлично подходит для крупномасштабной обработки веб-страниц с повторяющимися задачами. Требует навыков программирования.

- Обработка данных о товарах в электронной коммерции.

- Анализ данных статей с новостных сайтов.

- Простая настройка телефонного парсинга. Что такое телефонный парсер? Это сбор контактных номеров по заданному шаблону. Например, можно выделить все номера с определенным кодом города или только одинаковые.

- Сканирование всего домена для получения всех его URL-адресов.

- Множество функций для решения наиболее распространенных проблем с парсингом и веб-сканированием.

- Подробная документация, регулярные обновления.

Плагины для браузеров

Web Scraper

Плагин для Chrome, который помогает выполнять парсинг веб-страниц и сбор данных. Позволяет масштабировать проекты и обрабатывать несколько страниц сразу, есть возможности динамического извлечения данных.

- Все собранные данные находятся в локальном хранилище.

- Несколько типов выборки данных.

- Извлечение сведений с динамических страниц.

- Быстрый просмотр собранных данных.

- Экспорт извлеченных сведений в формате CSV.

- Функции парсера структуры сайта — импорт и экспорт соответствующих файлов формата Sitemap.

Outwit

Плагин для браузера Firefox, который легко загрузить из официального магазина Mozilla AMO. Есть 3 различных варианта ПО в соответствии с нужными требованиями: профессиональная, экспертная и бизнес-версия.

- Помогает распарсить контакты из интернета и электронной почты.

- Для получения данных с любых сайтов не требуются навыки программирования.

- Позволяет одним щелчком мыши управлять разными процессами, например, таким, как запустить парсинг на сотнях веб-страниц.

Simplescraper

Простой в использовании плагин для Chrome, позволяющий быстро спарсить данные с нужного сайта. Для этого потребуется указать нужные элементы и выполнить несколько простых настроек.

- Не нужно ничего дополнительно устанавливать.

- В среднем один сайт обрабатывается для передачи данных в API за 30 секунд.

- Возможен локальный парсинг или создание собственных шаблонов, которые быстро запускаются в облаке.

- Одновременная обработка тысяч веб-страниц одним щелчком мыши.

- Работает с сайтами с бесконечной прокруткой и динамически загружаемыми данными, а также с сайтами на JavaScript.

- Экспорт собранных данных в Google Таблицы — ведет автоматическую отправку данных.

- Глубокий парсинг по всем ссылкам с сайта, а затем и данных по каждой из этих ссылок.

- Позволяет запланировать работы по сбору информации — например, каждые 30 минут.

Dataminer

Один из самых известных плагинов для веб-сканирования и парсинга через Chrome и Edge. У него много функций по сравнению с другими — обычно плагины проще в использовании, чем десктопное ПО, но это не тот случай. Вполне подойдет даже для разработчиков как удобный и понятный инструмент.

- Может обрабатывать сайты с бесконечной прокруткой и разбиением на страницы, выполняет пользовательские JavaScript внутри браузера.

- Есть общедоступный список шаблонов, по которым можно выполнять поиск, чтобы ускорить процесс. Шаблон содержит список шагов и правил для парсинга сайтов.

- Для крупных сайтов, таких как Avito, Amazon или Ebay, можно спарсить товары с сайта одним щелчком мыши. Не придется вручную выбирать каждый нужный элемент.

Scraper

Плагин для Chrome, своего рода мини-парсер. Задание определенного запроса обеспечивает легкий сбор данных с веб-страниц. Плагин предлагает интеллектуальный анализ для облегчения работы, когда нужно быстро преобразовать данные в электронную таблицу. Задуман как простой в использовании инструмент для пользователей среднего и продвинутого уровня, знакомых с языком запросов XPath.

- Хороший парсер таблиц — быстро переносит данные с веб-страниц в электронные таблицы.

- Простой интерфейс.

- Идеальный выбор для онлайн-исследований.

- Легко использовать.

Data Scraper

Быстрое решение задачи, как программой парсить данные с сайта. Data Scraper может извлекать данные из любых HTML-кодов. Извлеченные данные сохраняются в электронных таблицах Excel. Им может пользоваться через Chrome кто угодно — от студентов и рекрутеров до аналитиков и менеджеров по рекламе.

- Может парсить списки данных и таблицы.

- Позволяет работу в автономном режиме.

- Собранные данные можно загружать в Google Таблицы и Excel.

- Поддерживаемые форматы вывода включают файлы XLS, CSV, XLSX и TSV.

- Предоставляет множество дополнительных функций, таких как поддержка разных языков и автоматический переход на следующую страницу сайта.

Частые вопросы

Парсинг и парсер — что это за слова?

Что такое парсеры и генераторы парсеров?

Для чего используют парсер?

Автоматизированный парсер — что это?

Автоматизированный, или автоматический, парсер — это программный код, который создается однократно. Затем он выполняет свои функции столько раз, сколько вам нужно. С помощью таких решений можно решать практически любые задачи для обработки заданной информации с нужной периодичностью. Например, сделать парсер информации о компании-конкуренте, чтобы он запускался раз в неделю.

Что такое парсер сайта?

Такие сервисы иногда называют парсерами текста с сайта — они в режиме онлайн собирают всю нужную информацию со статических или динамических веб-страниц, а затем преобразуют ее в нужный формат. Часто такие решения используют для глубокого анализа контента — сопоставления источников новостей, выявления плагиата, сбора определенной информации по темам и так далее.

Что такое парсер поисковых систем?

Это код, который анализирует выдачу поисковиков по нужным критериям. Можно, например, проводить парсинг в Рамблере результатов поисковой выдачи по определенным ключам каждый месяц. Или собирать информацию из Гугла, чтобы быстро узнать, на какой странице находится ваш сайт.

Что такое парсер слов?

Такой парсер предназначен для нахождения любых слов или фраз в текстах. Результаты выводятся в единый файл, поэтому их легко анализировать. Например, есть парсер статей для выявления определенных фраз и их частоты или парсер семантических признаков в ключах — так называемый key-parser, или парсер «кеев». Также подобные парсеры нередко используют для проверки правописания.

Подпишитесь на рассылку ROMI center:

Получайте советы и лайфхаки, дайджесты интересных статей и новости об интернет-маркетинге и веб-аналитике: